美团正式发布并开源其5600亿参数的大语言模型LongCat-Flash,该模型采用混合专家(MoE)架构,创新性地引入“零计算专家”机制,在推理速度和成本控制上表现卓越。

2025年9月1日,美团正式发布并开源其5600亿参数的大语言模型LongCat-Flash,该模型采用混合专家(MoE)架构,创新性地引入“零计算专家”机制,在推理速度和成本控制上表现卓越。

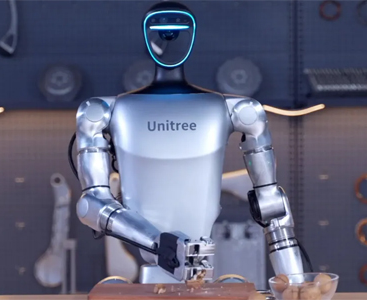

图源:美团

LongCat-Flash的突出之处在于,并非所有Token都同等重要,它能根据上下文需求,从总计5600亿参数中动态激活186亿至313亿参数。这种机制大幅提升了计算效率,使推理速度突破每秒100 Token,而每处理100万输出词元的成本仅5元。

在性能方面,LongCat-Flash在MMLU、ArenaHard、CEval等基准测试中表现亮眼,接近甚至超越DeepSeek V3.1与Qwen3等模型,尤其在指令遵循与智能体(Agent)任务中优势明显,能够调用外部工具完成复杂多步骤任务。目前,该模型已遵循MIT协议在Hugging Face和GitHub开源,相关代码也已适配SGLang和vLLM框架,旨在进一步降低企业级应用的门槛,推动大模型技术在更多领域的应用与创新。